Une sophistication qui précède la valeur

Dans les coulisses, Anthropic et OpenAI travaillent sur un problème plus fondamental que l'art d'écrire de bons prompts. Elles optimisent le « contexte » : l'ensemble des informations qu'un agent IA manipule pour accomplir une tâche. Compaction de l'historique, architectures multi-agents, retrieval « just-in-time »... Le vocabulaire technique s'étoffe, les architectures se complexifient.

Cette sophistication pose une question légitime : sur-ingénie-t-on des solutions avant d'avoir prouvé leur valeur ? Selon l'INSEE, seulement 10 % des entreprises françaises de plus de dix salariés utilisaient l'IA en 2024, loin du Danemark à 28 %. Pendant ce temps, des études optimistes évoquent 85 % d'adoption des agents IA en 2025. Le décalage entre annonces et réalité est vertigineux.

Les gains de productivité massifs promis restent une perspective de moyen-long terme, pas une réalité immédiate. Les technologies ne sont pas encore matures. Certes, 99 % des développeurs explorent les agents IA selon IBM, mais combien sont déployés en production avec des bénéfices mesurables ?

L'oligopole se dessine

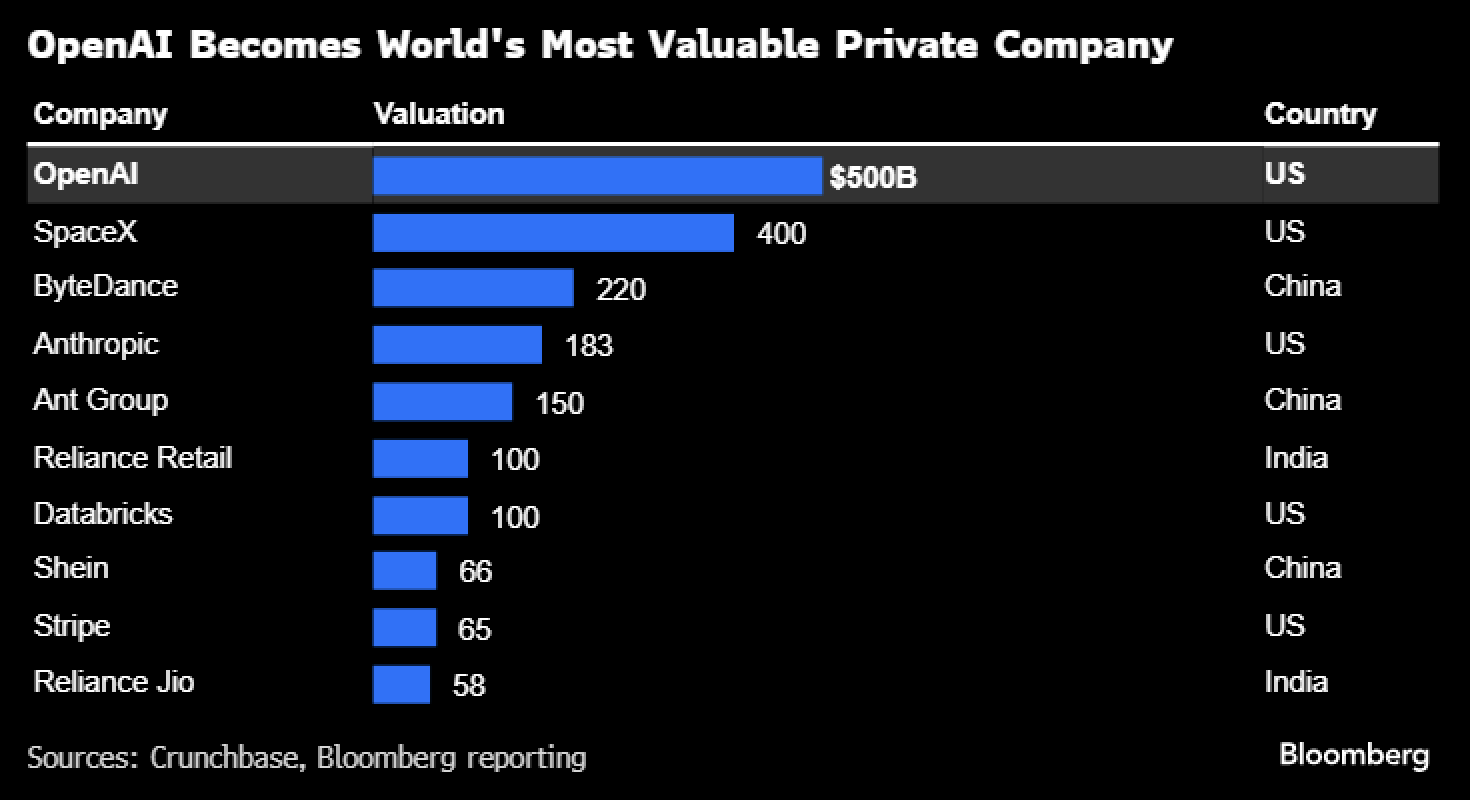

Ce marché naissant profite déjà à quelques géants. Anthropic à 183 milliards, OpenAI approchant 300 milliards, DeepSeek en Chine : ils se comptent sur les doigts d'une main. Les seuls agents véritablement fonctionnels à l'échelle sont ceux intégrés dans ChatGPT, Claude ou leurs équivalents chinois. OpenAI a lancé son « ChatGPT agent » en juillet 2025. Anthropic propose Claude Code. Les autres peinent à émerger.

Cette concentration rappelle celle des infrastructures IA : Nvidia concentre 85 % de ses revenus auprès de six clients, les « Sept Magnifiques » pèsent un tiers du S&P 500. Le paradigme des agents n'échappe pas à cette logique de consolidation autour de quelques champions. Ce n'est pas un marché fragmenté, mais un jeu à très grande échelle, avec des barrières à l'entrée considérables : puissance de calcul, données, expertise, et capacité à brûler du cash pendant des années.

Le contexte comme nouvelle rareté

Au cœur de cette révolution se trouve un concept contre-intuitif : le contexte est une ressource limitée. Les modèles souffrent de « context rot » : plus on leur donne d'informations simultanément, moins ils sont précis. Leur attention se dilue. Cette contrainte n'est pas temporaire. Elle est fondamentale et structurelle.

Nous n'aurons pas d'IA omnisciente qui nous connaîtrait parfaitement. L'agent aura toujours besoin qu'on lui donne accès aux bonnes données au bon moment. D'où l'émergence d'une ingénierie complexe : quelles informations inclure ? Quand les charger ? Comment les compresser ?

Cette contrainte crée de nouveaux business models. Le « context engineering » devient un métier. Des outils émergent pour standardiser l'accès aux données. Les entreprises investissent massivement dans la structuration de leurs bases de connaissances.

L'adoption attendra

Ces techniques sophistiquées ne faciliteront pas immédiatement l'adoption en entreprise. Ce n'est pas le context engineering qui démocratisera les agents, mais son intégration progressive et invisible dans les outils existants. Les équipes IT doivent creuser ces sujets maintenant, car ils structureront les applications de demain. Mais la diffusion prendra du temps.

L'histoire du prompt engineering est éclairante. À la sortie de ChatGPT en novembre 2022, personne ne savait ce qu'était un « prompt ». Deux ans plus tard, les collaborateurs maîtrisent cet art. Le context engineering suivra la même trajectoire : une technicité réservée aux spécialistes, qui se démocratisera graduellement dans les six mois à deux ans.

Les freins restent considérables : 53 % des entreprises citent la confidentialité des données, 40 % l'intégration, 39 % les coûts. Plus de 50 % des dirigeants de PME ne savent pas comment appliquer l'IA. Paradoxalement, les collaborateurs sont plus enthousiastes : un tiers pensent que l'adoption massive se fera dans l'année, les dirigeants tablent sur un à cinq ans.

Une révolution différente

Dans les années 1990, équiper un salarié avec un PC et Office coûtait 7 % d'un salaire annuel. Aujourd'hui, 20 dollars mensuels suffisent pour un chatbot puissant, soit 0,7 % du même salaire. Cette accessibilité fait que l'IA a débuté par les ménages avant les entreprises. On estime que 60 % des revenus d'OpenAI proviennent des particuliers.

Mais accessibilité économique ne signifie pas simplicité d'usage professionnel. Entre reformuler un email et orchestrer des workflows complexes, il y a un gouffre. Les entreprises devraient investir 109 milliards d'euros en France, 200 milliards via l'initiative européenne « InvestAI ». Mais ces investissements interviennent alors que la rentabilité reste hypothétique. OpenAI ne prévoit pas d'être rentable avant 2030. Anthropic brûle du cash malgré ses 5 milliards de revenus. Le secteur mise sur une promesse qui, pour l'instant, ne se reflète pas dans les statistiques de productivité.

Garder raison

Ces techniques sont importantes et structurantes. Elles permettent de construire des agents plus capables. Mais elles ne représentent qu'une brique parmi d'autres. Les entreprises françaises et européennes doivent s'y intéresser pour ne pas décrocher des leaders américains. Les DSI doivent former leurs équipes, expérimenter, structurer leurs données. Mais sans céder à la pression d'adopter des technologies immatures.

L'enjeu n'est pas de suivre la mode du « toujours plus », mais de créer de la valeur mesurable. Si les agents permettent de gagner 0,5 % de productivité par an, ce serait formidable. Sur quinze ans, cela représenterait 8 % de hausse, alors qu'elle stagne depuis une décennie en France. Mais gardons-nous des mirages. Les révolutions réelles prennent du temps, et la complexité finit toujours par se simplifier pour servir le plus grand nombre.

En attendant, le contexte reste une ressource précieuse. Pour les IA comme pour nous.

Martin Pavanello est co-fondateur de Mister IA, une agence de conseil en IA et un organisme de formation pour professionnels.